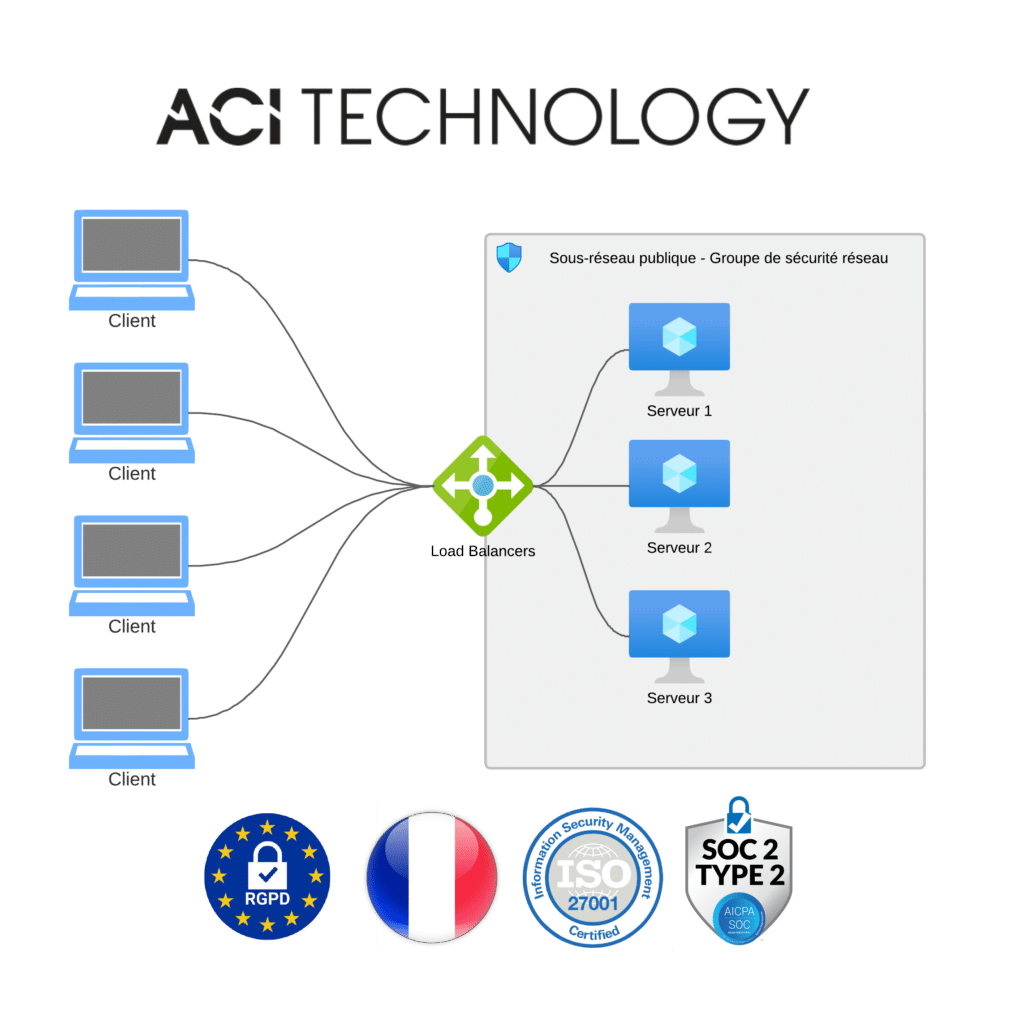

La répartition de charge (load balancing en anglais, littéralement équilibrage de charge) est une technique utilisée en informatique pour distribuer un travail entre plusieurs processus, ordinateurs, disques ou autres ressources.

Le principe de base du load-balancing (répartition de charge) consiste à interposer entre les consommateurs de la ressource et le pool de ressources un dispositif (le répartiteur) qui connaît l’état d’occupation de chaque ressource et qui est capable de diriger le consommateur vers la ressource la moins occupée, ou la plus facilement accessible.

Les ressources peuvent ne pas avoir la même capacité à satisfaire les besoins du consommateur (en vitesse de traitement, en bande passante, etc.), ce qui influe sur le mode de calcul du répartiteur.

Un exemple de répartition de charge de type Round-robin est effectué au niveau des serveurs DNS : ainsi, pour un nom de domaine précis, le serveur DNS possède plusieurs adresses IP. À chaque requête, le serveur DNS choisit l’adresse IP à inclure dans la réponse de manière à ce que chaque adresse IP soit présente dans les réponses de manière équitable.

Les différents accès au nom de domaine sont par conséquent répartis équitablement entre les différentes adresses IP.

Le principe de la répartition de charge s’applique aussi au domaine des connexions réseaux. Il existe plusieurs façons de mettre en place ce type de solution. On peut acheter un boîtier d’équilibrage de charge et l’administrer soi-même ou comme certaines entreprises le proposent : acquérir le boîtier et faire appel au service de supervision qui l’accompagne.